Aktuelle KI-Rechenzentren stehen bei der Skalierung vor zwei wesentlichen Engpässen, und herkömmliche Scale-{0}Up- und Scale-Out-Modelle haben Schwierigkeiten, den KI-Anforderungen im Gig{2}}-Maßstab gerecht zu werden:

Skalieren-Einschränkungen nach oben: Wird durch die Aufrüstung einzelner Systeme oder Racks erreicht (z. B. Erhöhung der GPU-Anzahl oder Verbesserung der Leistung einzelner -Geräte), wird jedoch durch Leistungsobergrenzen von Infrastrukturen wie Wasserkühlung eingeschränkt. Bestehende Rechenzentren verfügen über physikalische Grenzwerte für die Leistungsaufnahme und Wärmeableitung, wodurch eine unendliche Steigerung der Rechendichte pro Rack oder Rechenzentrum verhindert wird.

Scale--Out-Einschränkungen: Erweitert durch das Hinzufügen von Racks und Servern zur Skalierung von Clustern, ist jedoch durch den physischen Platz an einem einzelnen Standort begrenzt, wodurch die Gerätekapazität streng begrenzt wird.

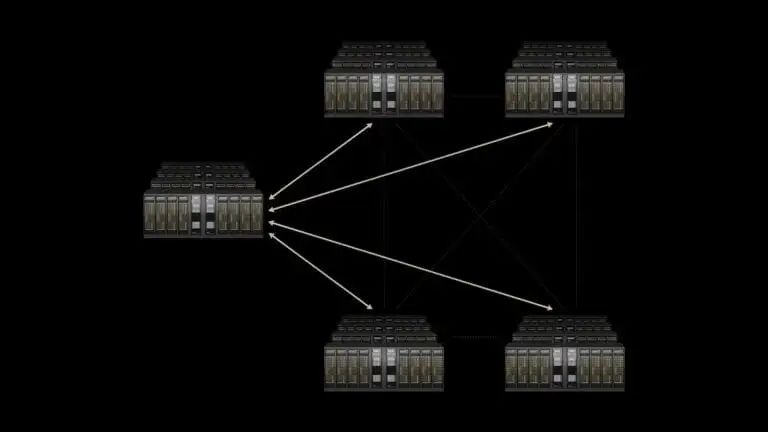

Um dieses Dilemma zu überwinden, schlägt NVIDIA die neue Dimension der „Skalierung“ vor, die die Netzwerkkommunikation zwischen geografisch verteilten Rechenzentren optimiert, um die Zusammenarbeit verteilter KI-Cluster als Ganzes zu ermöglichen. Jensen Huang, Gründer und CEO von NVIDIA, beschreibt diese überregionale KI-Superfabrik als Schlüsselinfrastruktur für die industrielle KI-Revolution, mit Spectrum-XGS als zentralem Technologie-Enabler.

Kerntechnologien von Spectrum-XGS

Spectrum-XGS ist keine völlig neue Hardwareplattform, sondern eine Weiterentwicklung des bestehenden Spectrum{1}X-Ethernet-Ökosystems von NVIDIA. Seit seiner Einführung im Jahr 2024 hat Spectrum-X über die SN5600-Switches und BlueField{{11}3-DPUs der Spectrum-4-Architektur eine 1,6-mal höhere generative KI-Netzwerkleistung als herkömmliches Ethernet geliefert und ist damit zur Mainstream-Wahl für KI-Rechenzentren mit NVIDIA-GPUs geworden. Der Durchbruch bei Spectrum-XGS liegt in drei algorithmischen Innovationen und Hardware-Synergien, die Kommunikationslatenz-, Überlastungs- und Synchronisierungsherausforderungen in überregionalen GPU-Clustern bewältigen.

1.Kernalgorithmen: Dynamische Anpassung an Netzwerkeigenschaften über große Entfernungen

Der Kern von Spectrum-XGS besteht aus einer Reihe von „entfernungsbewussten Netzwerkoptimierungsalgorithmen“, die Schlüsselparameter der datenzentrumsübergreifenden Kommunikation in Echtzeit analysieren (Entfernung, Verkehrsmuster, Überlastungsgrade, Leistungsmetriken) und Netzwerkrichtlinien dynamisch anpassen:

Entfernung-Adaptive Staukontrolle:Im Gegensatz zur einheitlichen Behandlung aller Verbindungen durch herkömmliches Ethernet passen die XGS-Algorithmen von Spectrum-Überlastungsschwellenwerte automatisch an die tatsächlichen Entfernungen zwischen Rechenzentren an (unterstützen derzeit Bereitstellungen bis zu Hunderten von Kilometern) und vermeiden so Paketverluste oder -staus bei Übertragungen über große Entfernungen.

Präzises Latenzmanagement:Durch feinkörniges adaptives Routing pro {{0}Paket- wird Latenzjitter bei Paketneuübertragungen in herkömmlichen Netzwerken eliminiert. Jitter ist eine kritische Gefahr in KI-Clustern: Wenn eine einzelne GPU aufgrund einer Verzögerung zurückbleibt, müssen alle zusammenarbeitenden GPUs warten, was sich direkt auf die Gesamtleistung auswirkt.

Ende-bis-Telemetrie beenden: Die Echtzeiterfassung vollständiger{{1}Link-Leistungsdaten von GPUs zu Switches und Cross-{2}Daten--Center-Links liefert Rückmeldungen auf Millisekundenebene-für algorithmische Anpassungen und gewährleistet so eine dynamische Anpassung des Netzwerkstatus an die Anforderungen der KI-Arbeitslast.

2. Hardware-Synergien: Nutzung der hohen-Bandbreitenbasis von Spectrum-X Ecosystem

Spectrum-XGS erreicht optimale Leistung in Kombination mit spezifischer NVIDIA-Hardware:

Spectrum-X-Schalter: Als zugrunde liegendes Netzwerk-Backbone, das eine hohe Portdichte und eine Weiterleitung mit geringer{0}}Latenz bietet.

ConnectX-8 SuperNIC: 800 Gbit/s AI-dedizierter Netzwerkadapter für Hochgeschwindigkeitsdatenübertragung zwischen GPUs und Switches.

Blackwell-Architektur-Hardware: Wie B200-GPUs und GB10-Superchips, tief integriert in Spectrum-XGS, um die End-zu-Endlatenz zu reduzieren. NVIDIA validiert durch NCCL-Benchmarks (Collective Communications Library): Spectrum-XGS steigert die Kommunikationsleistung zwischen GPUs über mehrere Rechenzentren hinweg um das 1,9-fache und kontrolliert gleichzeitig die Ende{10}}zu-End-Latenz auf etwa 200 Millisekunden-ein Niveau, das sich anfühlt reaktionsschnell und verzögerungsfrei für Benutzerinteraktionen und erfüllt Echtzeitanforderungen für KI-Inferenz.

Vollständige-Stack-Optimierung für KI-Training und Inferenzeffizienz mit Spectrum-XGS

Spectrum-XGS ist keine isolierte Technologie, sondern eine wichtige Ergänzung zum Full--Stack-KI-Ökosystem von NVIDIA. In dieser Version enthüllte NVIDIA außerdem Leistungsverbesserungen auf Software-{3}}Ebene, die mit Spectrum-XGS für die Hardware--Algorithmus--Software-Zusammenarbeit synergetisch arbeiten:

Dynamo-Software-Upgrade: Optimiert für die Blackwell-Architektur (z. B. B200-Systeme), um die Inferenzleistung von KI-Modellen um das bis zu Vierfache zu steigern und den Rechenverbrauch für große Modellinferenzen erheblich zu reduzieren.

Spekulative Dekodierungstechnologie: Verwendet ein kleines Entwurfsmodell, um das nächste Ausgabetoken des Haupt-KI-Modells im Voraus vorherzusagen, wodurch die Berechnung des Hauptmodells reduziert und die Inferenzleistung um weitere 35 % verbessert wird. Dies eignet sich besonders für Konversationsinferenzszenarien in großen Sprachmodellen (LLMs).

Dave Salvator, Abteilungsleiter für beschleunigtes Computing bei NVIDIA, erklärte, dass das Hauptziel dieser Optimierungen darin bestehe, ehrgeizige Agenten-KI-Anwendungen zu skalieren. Ganz gleich, ob Sie große Modelle mit Billionen-Parametern trainieren oder KI-Inferenzdienste für Millionen gleichzeitiger Benutzer unterstützen, die Kombination von Spectrum-XGS und dem Software-Ökosystem liefert vorhersehbare Leistung.

Frühe Anwendungen und Branchenauswirkungen von Spectrum-XGS

Erste Benutzer: CoreWeave Pioneers Cross-Domain AI Super FactoryDer GPU-Cloud-Dienstleister CoreWeave gehört zu den ersten Anwendern von Spectrum-XGS. Der Mitbegründer und CTO des Unternehmens, Peter Salanki, merkte an, dass diese Technologie seinen Kunden den Zugriff auf KI-Funktionen im gigantischen Maßstab ermöglichen und so Durchbrüche in allen Branchen beschleunigen wird. Beispielsweise unterstützen wir ultra-große-KI-Projekte wie die Stargate-Initiative von Oracle, SoftBank und OpenAI.

Branchentrends: Ethernet ersetzt InfiniBand als AI-Netzwerk-MainstreamObwohl InfiniBand im Jahr 2023 etwa 80 % des Marktes für KI-Backend-Netzwerke hielt, verlagert sich die Branche schnell auf Ethernet. Die Entscheidung von NVIDIA, Spectrum-XGS auf Ethernet zu entwickeln, steht im Einklang mit diesem Trend:

Kompatibilitäts- und Kostenvorteile:Ethernet ist der universelle Standard für globale Rechenzentren, Netzwerkingenieuren vertrauter und kostengünstiger in der Bereitstellung als InfiniBand.

Prognosen zur Marktgröße:Daten der Dell'Oro Group zeigen, dass der Markt für Ethernet-Rechenzentrums-Switches in den nächsten fünf Jahren ein Volumen von fast 80 Milliarden US-Dollar erreichen wird.

NVIDIAs eigenes Wachstum: 650 Gruppenberichte weisen darauf hin, dass NVIDIA der „am schnellsten{1}wachsende Anbieter“ auf dem Markt für Rechenzentrums-Switches im Jahr 2024 ist. Der Umsatz im Netzwerkgeschäft erreichte im dritten Quartal (Ende 27. April) 5 Milliarden US-Dollar, was einer Steigerung von 56 % gegenüber dem Vorjahr entspricht.

Die Einführung von Spectrum-XGS erweitert NVIDIAs Full--Stack-Monopolstrategie in der KI-Infrastruktur und löst gleichzeitig neue Wettbewerbsdynamik aus:

NVIDIAs vollständiges-Stack-Layout: Von GPUs (Blackwell), Verbindungen (NVLink/NVLink Switch), Netzwerken (Spectrum-X/Spectrum-XGS, Quantum-X InfiniBand) bis hin zu Software (CUDA, TensorRT-LLM, NIM-Mikrodienste) hat sich NVIDIA gebildet ein geschlossener Kreislauf, der „Compute-Connect-Software“ für die KI-Infrastruktur abdeckt. Spectrum - Cross-Data-center (Spectrum-XGS).

Antworten der Wettbewerber: Broadcoms frühere SUE-Technologie verfolgt ähnliche Ziele wie Spectrum-XGS und zielt darauf ab, die Ethernet-Leistung zu optimieren, um die Lücke zu InfiniBand zu schließen. Darüber hinaus beschleunigen Anbieter wie Arista, Cisco und Marvell KI--dedizierte Ethernet-Switches, während sich der Wettbewerb auf die Leistung-Kosten-Ökosystemkompatibilität konzentriert.

Der Kernwert von Spectrum - Da Strom und Land zu harten Grenzen für einzelne Rechenzentren werden, werden stadt- und länderübergreifende KI-Superfabriken zur Kernform für KI-Anwendungen der nächsten{6}Generation (z. B. allgemeine künstliche Intelligenz, große-Agentencluster).

Gilad Shainer, Senior Vice President der Netzwerkabteilung von NVIDIA, gab auf der Hot-Chips-Konferenz eine Vorschau: „Physikalische Glasfasernetzwerke über mehrere Datenzentren hinweg gibt es schon lange, aber Softwarealgorithmen wie Spectrum{2}XGS sind der Schlüssel zur Erschließung der wahren Leistung dieser physischen Infrastrukturen.“